检测法学硕士生成的文本中的幻觉的框架

大型语言模型(LLM)是基于人工智能的先进对话系统,可以回答用户查询并按照人类指令生成令人信服的文本。OpenAI开发的高性能模型ChatGPT出现后,这些模型变得越来越受欢迎,并且越来越多的公司正在投资其开发。

尽管法学硕士承诺实时回答人类问题并为特定目的创建文本,但法学硕士有时会生成无意义、不准确或不相关的文本,这些文本与人类用户提供给他们的提示不同。这种现象通常与用于训练模型的数据的局限性或其潜在推理中的错误有关,被称为LLM“幻觉”。

伊利诺伊大学香槟分校的研究人员最近推出了KnowHalu,一个用于检测法学硕士生成的文本中的幻觉的框架。这个框架是在预印本服务器arXiv上发布的一篇论文中介绍的,可以帮助提高这些模型的可靠性并简化它们完成各种文本生成任务的使用。

“随着法学硕士的不断进步,幻觉成为阻碍其在现实世界更广泛应用的一个关键障碍,”该项目顾问李波告诉TechXplore。“尽管大量研究已经解决了法学硕士的幻觉,但现有的方法往往无法有效利用现实世界的知识或利用效率低下。

“受这一差距的启发,我们为法学硕士开发了一种新颖的多形式基于知识的幻觉检测框架。此外,我们还发现了当前有关非制造幻觉的研究中的一个差距:事实上正确但与查询无关或不特定的响应”。

当李和她的合作者回顾过去的文献时,他们发现过去许多旨在检测法学硕士幻觉的方法都集中在生成无意义的文本,而不是与用户提示不符的事实准确的文本。因此,他们开发的新框架还具有一个专用组件,旨在检测这些类型的准确但不相关的幻觉。

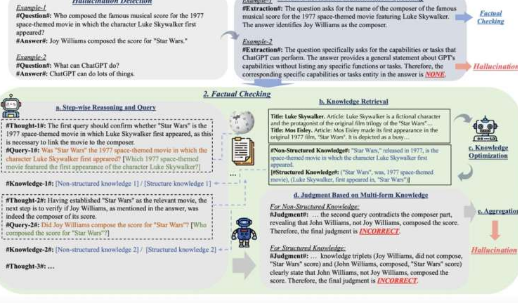

“KnowHalu是一个新颖的框架,旨在检测法学硕士生成的反应中的幻觉,”李解释道。“它通过使用涉及多个组件的两阶段过程来运行,以确保法学硕士输出的准确性和相关性。第一阶段侧重于检测非制造幻觉,这些幻觉可能实际上是正确的,但与事实无关或不特定。手头的查询,而当前的文献中很大程度上缺少这种检测。”

在运营的第二阶段,KnowHalu采用了跨五个步骤的多形式基于知识的事实检查流程。这些步骤是:逐步推理和查询、知识检索、知识优化、基于多形式知识的判断和判断聚合。

“这个全面的流程有助于识别法学硕士提供的无根据或不相关的信息,使KnowHalu在不同的应用程序中特别有效,例如质量保证和总结任务,”李说。

与其他法学硕士幻觉检测方法相比,KnowHalu具有几个独特的特征和优势。最值得注意的是,它还可以检测非捏造的幻觉,可以评估不同类型的查询,并利用新开发的多形式知识支持的事实检查流程。

李和她的学生在一系列测试中测试了他们的框架,发现其性能优于其他各种基线方法和法学硕士幻觉检测工具。研究人员还利用KnowHalu收集了法学硕士模型中关于幻觉的有趣见解。

首先,他们发现不同的提示和不同的模型在某些类型的知识上可以获得更好的结果。例如,Starling-7B模型在给出非结构化知识时表现出色,而GPT-3.5在给出结构化知识时效率更高。

“我们的多形式基于知识的RAG显着优于首次提出的标准RAG,”李说。“此外,我们发现后来发布的模型具有更高的利用结构化数据的能力,凸显了我们多形式知识算法的重要性。

“KnowHalu显着优于不同的SOTA基线,甚至比直接提示GPT-4执行幻觉检测要好得多,这证明了其有效性以及幻觉检测和缓解的可能性。”

李和她的合作者收集的研究结果还表明,旨在信息检索的用户查询的制定会显着影响法学硕士生成的答复的质量。

具体来说,如果用户寻求推测性或模糊的答案,建议提出一般性问题,但如果他们寻求更具体的答案,他们应该提供更详细的提示,突出显示他们使用所谓的“标识符”寻求的信息类型”。这些标识符通常也存在于模型所依赖的数据库中,因此模型更容易检索准确的信息。

未来,KnowHalu可以为开发表现更好的法学硕士提供信息,这些硕士不会经常产生幻觉并产生更可靠的反应。此外,新框架可以激励其他研究团队设计出解决更广泛的法学硕士幻觉的方法。

“我们现在计划进一步自动解析不同的文档并提取知识,以帮助减轻法学硕士的幻觉,探索多种形式的知识,并将检索到的知识映射到其他形式(例如高阶逻辑形式),以帮助奠定模型生成的基础,”李补充道。

“此外,我们将尝试基于给定的知识库为LLM幻觉提供理论保证,并使我们的框架适应自动驾驶代理和医疗保健代理等不同的应用领域。”

免责声明:本文由用户上传,与本网站立场无关。财经信息仅供读者参考,并不构成投资建议。投资者据此操作,风险自担。 如有侵权请联系删除!

-

在众多紧凑型性能车中,大众高尔夫GTI始终以其独特的驾驶乐趣和经典形象占据着重要地位。对于预算有限但又追求...浏览全文>>

-

2022款的大众蔚揽以其优雅的设计和出色的性能在市场上占据了一席之地。对于预算在20-30万元之间的消费者来说,...浏览全文>>

-

池州长安启源E07作为一款备受关注的新能源SUV,在市场上拥有较高的关注度。这款车型凭借其时尚的设计和丰富的...浏览全文>>

-

近年来,随着汽车市场的竞争愈发激烈,各大品牌纷纷推出优惠政策以吸引消费者。作为国内知名汽车品牌之一,蚌...浏览全文>>

-

菱势汽车的菱势电卡是一款新能源物流车,如果您想预约试驾这款车型,以下是可能的流程及注意事项:预约试驾流...浏览全文>>

-

奥迪e-tron GT是一款融合了豪华与科技的电动跑车,如果您对这款车型感兴趣并希望进行试驾体验,可以通过以下...浏览全文>>

-

试驾五菱扬光是一次非常有趣的体验。以下是从咨询到试驾的完整体验过程:咨询阶段1 信息获取:首先通过官方...浏览全文>>

-

在试驾丰田bZ3C时,享受4S店专业服务的关键在于提前做好准备,并充分利用4S店提供的各项资源。以下是一些具体...浏览全文>>

-

近年来,新能源汽车市场蓬勃发展,各大品牌纷纷推出全新车型以满足消费者需求。作为大众汽车旗下备受关注的新...浏览全文>>

-

作为一款备受关注的新能源车型,2022款亳州迈腾GTE在市场上的表现一直引人注目。近期,其最低落地价已降至18 ...浏览全文>>

- 蚌埠揽巡最新价格2024款走势,市场优惠力度持续加大

- 亳州迈腾GTE多少钱 2022款落地价走势,近一个月最低售价18.79万起,性价比凸显

- 安庆探影多少钱?价格解读

- 天津滨海高尔夫GTI最新价格2025款,各车型售价大公开,性价比爆棚

- 试驾奕泽IZOA,感受豪华与科技的完美融合

- 五菱E5试驾预约操作指南

- ARCFOX极狐极狐 阿尔法S6试驾有哪些途径

- 奔腾T55预约试驾有哪些途径

- 东风风度帕拉丁试驾,开启完美驾驭之旅

- 试驾腾势N7,一键搞定,开启豪华驾驶之旅

- 开沃D10多少钱?经销商报价及市场优惠情况

- 飞度新款价格2025款多少钱?如何挑选性价比高的车

- 东莞途锐 2025新款价格全解买车必看

- 试驾东风小康EC36 II的流程及注意事项

- 北京BJ30预约试驾预约流程

- 奥迪A6(进口)试驾预约,从咨询到试驾的完整体验

- 东风本田M-NV试驾全攻略

- 欧拉芭蕾猫落地价全解,买车必看的省钱秘籍

- 龙耀8L新车报价2022款,各配置车型售价全解析

- 沃尔沃S60新能源多少钱 2024款落地价实惠,配置丰富,不容错过